반응형

spark 기본 UI는 spark application이 종료되면 접속할 수 없다. 이전 application 로그를 확인하기 위해서 spark history 서버를 사용한다.

./$SPARK_HOME/conf/spark-defaults.conf 설정

spark.master spark://<master ip>:7077

spark.eventLog.enabled true

spark.eventLog.dir hdfs:///sparklog

spark.history.fs.logDirectory hdfs:///sparklog

spark.history.provider org.apache.spark.deploy.history.FsHistoryProviderspark application 로그를 hdfs에 저장하는 설정이다. hdfs에 /sprklog 경로생성을 미리 해두자.

spark.master에 master ip를 설정하는 경우는 spark가 standalone 모드로 구동될 때이다.

아래 글을 참고해주세요 ~

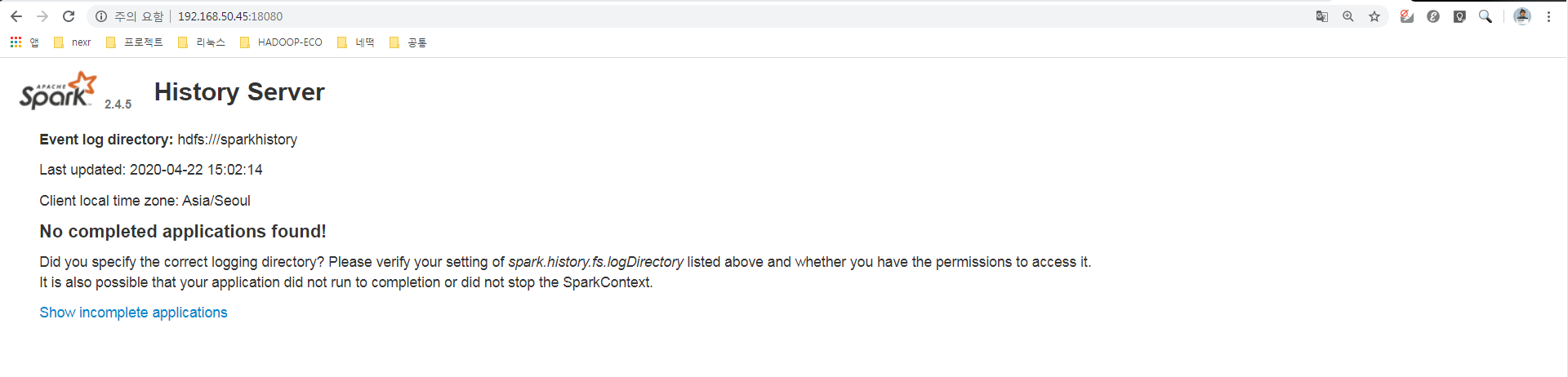

spark history 서버 구동

./$SPARK_HOME/sbin/start-history-server.sh

기본포트는 18080이다. http:///<spark-history-server ip>:18080으로 접속하여 웹UI를 확인한다.

Spark를 Yarn 클러스터 모드로 돌리는 경우라면 아래와 같이 설정한다.

./$SPARK_HOME/conf/spark-defaults.conf 설정

spark.master yarn

spark.eventLog.enabled true

spark.eventLog.dir hdfs:///sparklog

spark.history.fs.logDirectory hdfs:///sparklog

spark.yarn.historyServer.address <historyserver ip>:18082 #기본 포트는 18080

spark.history.provider org.apache.spark.deploy.history.FsHistoryProvider

반응형

'BigData 기술 > Spark' 카테고리의 다른 글

| jupyter 노트북에서 pyspark 사용하기 (2) | 2020.04.28 |

|---|---|

| docker로 spark-hadoop-cluster 구축하기 (4) | 2020.04.24 |

| [spark] 리눅스 환경에서 maven + spark + scala (920) | 2019.06.28 |

| [spark] 아파치 스파크 클러스터 종류 (2) | 2019.06.27 |

| [spark] 아파치 스파크 설치 및 환경설정 (2) | 2019.06.24 |

댓글